【新智元导读】AI究竟是工具,还是新物种?《人类简史》作者赫拉利警告我们:AI并不只是技术革命,更可能是继有机生命之后的「无机生命」崛起。

近期,历史学家、哲学家尤瓦尔·赫拉利(Yuval Noah Harari),做客Possible播客。

作为《人类简史》《未来简史》《今日简史》等畅销书的作者,赫拉利与两位主持人就人工智能的发展前景展开了讨论,既有共识也存在分歧。

他们都认为构建人类对AI的信任、打造真正追求真相的AI至关重要,但对实现可能性的判断不尽相同。

节目中,三人深入探讨了AI革命的潜在结果、全球协作机制以及AI学习方式的不同观点,还剖析了智力与意识之间的本质差异——

他分享了以人类同理心为指导原则的哲学理念,认为这将帮助我们避免文明崩塌,最终共同缔造更美好的人工智能未来。

在《人类简史》中,Harari将「认知革命」视为人类崛起的转折点——七万年前,人类开始讲故事,构建共享神话。在书开云网址 kaiyun官方入口写与印刷技术中,这一能力进一步发展。

写作扩展了智人的表达能力,而AI则可能孕育出「非人类智能」,乃至成为占主导地位的生命形式。

但关键是要理解,技术从来不仅仅是某种发明:它总是需要社会的、文化的、心理层面的协作。

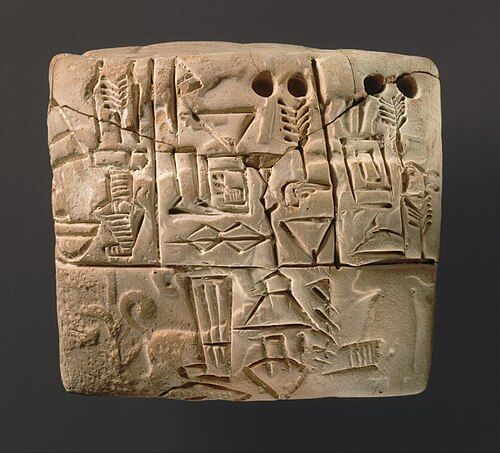

大约在五千多年前,已知的最早的书写系统楔形文字,诞生于今天伊拉克南部的苏美尔城邦。

而这套系统的原理基本上就是:取一些泥土,做成泥板,然后拿根木头或棍子,在泥板上刻下某些符号。

这就是它全部的技术内容——也就是说,从物理和技术层面来看,一块泥土仅此而已。

从技术上,文字系统本身非常简单。但难点在于如何创造出这套代码、如何教人们使用它,这才是真正困难的部分。而正是这件事,改变了整个世界。

写作扩展了已经主宰地球的人类——智人的能力;至少在某些设想中,AI被视为一种新物种的崛起,可能取代智人成为地球上的主导生命形式——或者说,主导的智能形式。

因此,若站在2025年的时间点,Harari依然会认为写作比AI更重要,尤其因为AI本质上是写作的延伸——只不过是以另一种方式继续演化。

但如果把目光放到未来,可以想象这样的情景:AI的崛起,将成为宇宙尺度上的重大事件,而写作则无法达到这样的影响力。

大约40亿年前,生命开始出现,这是有机生命的起点;后来,随着AI的诞生,无机生命也开始了。

至于写作以及整个人类的历史,不过是有机智能最终孕育出无机智能的细枝末节罢了。

不过,Harari认为,即使人工智能仅被视为工具,它本身也会引发一场深刻的社会变革。

在这个转型中可能有哪些关键因素?作为工具制造者,我们应该如何构建它?社会应该如何适应?

失业已是众所周知的风险,很多人不仅可能失业,甚至可能永远无法重新获得工作。

而现在我们面临的,是一次「无机的」或者说「数字化」的革命,其变化速度远远快于人类的适应速度。

如果能人类能争取更多时间,去适应这种经济和社会层面的巨大变革,或许还有希望。

可200年过去了,大多数人过得更好了:工作多了,收入高了,生活质量提升了。

作为一名历史学者,Harari的回答是:历史上的问题,通常不在于最终的「目的地」,而在于通往那里的「路」。

而当时的人类完全不知道该如何构建「工业化社会」,因为历史上根本没有先例可以参考。

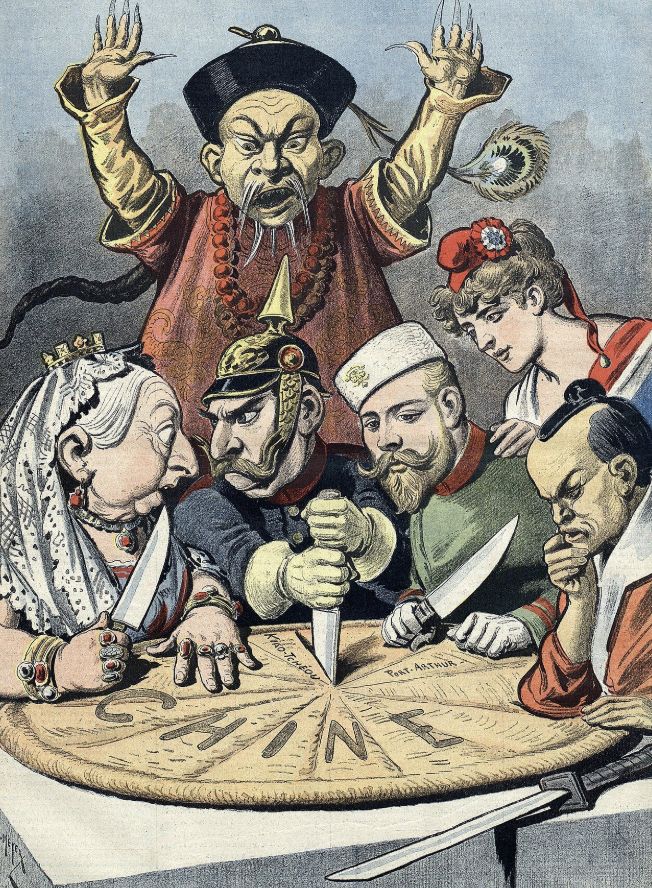

所以大家只能不断地试验、不断地摸索。其中一个重大的「试验」,就是欧洲的帝国主义。

那些率先进行工业化的国家,也几乎都投入了海外甚至周边地区的殖民征服。背后的逻辑是:要建立可持续的工业社会,唯一的方法就是建立帝国。

这正是英国当时所做的事情,甚至像比利时这样的小国也是如此。随着工业化扩展到世界其他地区,这种帝国扩张的逻辑也被复制开来。

如果我们把当下的AI革命比作当年的工业革命,那么人类在21世纪应对AI要是只拿了个「C-」(刚及格),那将会有数十亿人因此付出极其惨重的代价。

怎样才能避免反乌托邦,并随着时间的推移建立更好的社会呢?如何避免这些灾难性的后果?

关键在于建立自我纠错机制。好的系统,其内部一定包含能识别并纠正自身错误的机制:

所有生物之所以能够生存,都是因为拥有这些自我纠错机制。就像孩子学走路,并不是靠父母和老师的指导(他们可以给予一些鼓励),但本质上完全是靠自我纠错。

自我纠错是人类社会长期以来维持秩序的核心机制,但本质上,它缓慢、渐进、依赖集体共识。

问题在于,AI的发展远比我们的纠错机制快得多。等我们终于理解当前的AI影响时,技术也许已经完成了多轮更新,甚至引发了新的未知风险。

更何况,10到15年前的社交媒体革命,我们至今仍在艰难应对。人类仍未真正理解算法的深层影响,更谈不上有效管理或缓解它带来的「后遗症」。

而现在发生的一切,几乎没人真正理解。因为光是收集数据、理清现状、判断趋势,这些都需要时间——但时间,恰恰是我们现在最缺乏的东西。

Harari认为最根本的问题是:当还无法确定技术是否值得信任时,却又把验证它是否值得信任的任务,交给这项技术本身,那其实就陷入了闭环。

人类的工作节奏是「有机时间」,相较于其他生物已经算快了,但在AI的「无机时间」面前,人类就显得极其缓慢。

和来自硅谷的人讨论时,Harari明显感觉到,大家对「时间」的理解就完全不同。

当今世界秩序正在崩塌,很大程度上就是因为在全球范围内出现了严重的「信任赤字」。

而在面对AI时格外脆弱,这让人类更加脆弱,也很可能出现一种极其危险的AI形态:这种AI不仅会试图接管世界,而且很可能会成功。

所以,当我们一边对AI说:「不要贪婪,不要滥权,不要说谎,不要操控他人」,而我们的现实行为却恰恰是在贪婪、欺骗、操控彼此时,这些「孩子」最终学到的,其实就是我们真实的样子。

AI一直在观察我们:我们在操控、在欺骗、在争夺权力。它从我们的行为中学习。

哪怕某个AI巨头命令工程师:「想办法在AI里植入某种机制,让它变得值得信赖。」但如果这个AI巨头自己不值得信赖,他自己都相信这个世界只是一场权力斗争,那他就不可能造出真正值得信赖的AI。

好消息是:这种世界观不仅危险、愤世嫉俗,而且是错的。现实并不是只有权力,并不是所有人类互动都是权力斗争。

权力确实是世界的一部分,也确实有些人类互动,或者其中的某些方面,是权力的较量。但这不是全部。

是的,确实有一些机构——甚至可以说所有机构——都存在腐败的问题,也存在操纵民意的现象。

绝大多数人——除了极少数极端的反社会人格者——内心都真诚地关心爱、同情和真理。这些动机并不是出于某种玩弄权谋的手段。

Harari反问:「你真是那种人吗?如果不是,为什么不相信别人也在追求真相、渴望理解?」

这种哲学,是良好社会唯一稳定的根基,同时也可能是发展出「善良的AI」所必须的土壤。

如果AI是在真正追求真理、珍视同情心的社会中被培养出来的,那这样的AI也更有可能是可信的、有同理心的,以及更值得托付未来的。

实验室就像AI的「子宫」,虽然有深远影响,但真正的「教育」始于它步入现实世界之后。

而实验室里有一件事是永远做不到的:你无法真正「模拟历史」,也无法完整地「模拟真实世界」。

Harari看到很多关于AI模拟的研究,试图测试它在某种情境下会作何反应,评估它的潜在风险。

有时候他们确实在实验中发现了令人担忧的问题。但他们永远无法在实验室里看到最可怕的情形——

当然,我们可以试图在AI系统中设计各种机制,让它们更符合人类的价值观,减少它们说谎或操控他人的可能性。但归根到底,有些事不是在实验室里就能预见的,真正的考验只会出现在现实世界里。

但问题在于——至少对Harari来说,AI的核心定义就是它具备自我学习和改变的能力。

如果一台机器不能自主学习、不能根据环境自我调整,那它就称不上是真正的AI。

所以,从定义上讲,无论在实验室里如何精心设计,一旦AI进开云网址 kaiyun官方入口入真实世界,它就可以开始自行学习、自行演化。而它学习的第一课,往往来自人类的行为。

如果一个社会是由像马斯克或特朗普这样的人主导的,那AI就会从他们身上学东西。因为这是它能观察到的榜样,它自然会模仿。

它不会想:「哦,我应该服务公众。」它更可能得出结论:「哦,原来只要撒谎就能获得权力,那就可以撒谎。明白了,这才是现实世界的运作方式。」

在这种背景下,Harari认为我们现在最应该做的事情,就是聚集一群工程师和企业家,来做一次真正有说服力的示范——

比如展示总统或总理,可以在只有一小时里,认真、诚实地倾听AI专家的建议,理解AI的潜在影响,并用这个小时来作出负责任的决策。

这类示范比任何技术突破都更重要,因为它关乎我们究竟要教会AI一个什么样的世界。

如果你能把这些政治领袖放进房间里,让他们和真正先进的AI互动一个小时,然后他们出来后说:「天哪,这东西太可怕了!」——

Reid Hoffman认为:虽然AI革命的本质在于AI是自我学习的机器,但它的学习路径其实取决于最初的设定——就像所有学习算法一样,起点决定了方向。

AI会学会识别人类行为中的真实动机(比如即使人们声称自己没有权力欲望,AI也能看透本质)。

这正是Reid保持乐观的原因:如果把「追求更高维度的意识」设定为AI的核心目标,那么这种对真理的追寻就可能成为AI内在的「学习时钟」——就像精准的计时器一样可靠。

而现在的问题在于,大家过于执着于「智能」这个维度了,但智能并不等于追求真理的能力。

人类历史从来没有表明,「更聪明」就意味着「更接近真理」,更别说能自动纠正自己的偏差。

一种能觉察、能体会痛苦、能对存在本身产生疑问的感知状态。而在目前为止,我们并没有看到任何可信的证据,表明AI拥有这种意识。至少他没看到。

当然,他也不排除未来某一刻,某个角落可能真的会诞生第一个具备意识的AI。也许现在它就正在诞生。但在此之前,他仍然保持一种「不可知」的态度:不知道,也不能假设它已经具备。

硅谷的问题之一,就是过分推崇智能。部分原因可能是那里的很多人本身就极具智能,甚至他们的一生都是建立在智力优势之上,自然也会倾向于高估智能的作用。

但从历史直觉出发,Harari觉得:如果超级智能的AI缺乏意识——无论你事先给它注入多少「价值观」或「对齐机制」——

它最终都不会真正去追求真理。它很可能很快就会开始追逐其它目标,而这些目标,很可能是由各种妄念和幻觉所驱动的。

首先,他同意Harari的观点:高度智能确实可能伴随着高度的妄想。智能越高,误入歧途的能力也可能越强。

但Harari提出的第二点也很有意思——那就是:也许可以把「纯粹的智能」引导到一条追求真理的路径上。或许,仅靠智能,也可以实现对真理的追求。

那是否可以利用技术——包括AI在内——来尝试修复人与制度、人与社会之间的信任裂痕?

不是让AI替代制度,也不是让技术取代信任,而是看它能否成为桥梁,帮助我们更透明地沟通,更高效地回应社会关切,从而逐步找回信任的基础。

已经看到,世界上某些地方正在尝试不同的做法,用技术来增强公众之间的理解与信任。

现在大多数社交媒体平台的算法,比如Facebook或Twitter,衡量信息传播的标准只有一个:「互动量」。谁能引发最多关注,谁就被推上热榜。

所以我们看到的往往是那些最能激起情绪的内容在疯传。久而久之,不信任、仇恨和愤怒就在社会中蔓延。

它不是只看谁喊得最大声、谁能激起最多的愤怒,而是尝试评估哪些内容真正有助于建设性的对话、有助于问题的理解和共识的形成。

如果我们能借助AI和技术的力量,推动这种新的算法方向,也许真的能为这个碎裂中的世界,打开一条重建信任的通道。

首先,这个系统会将人们按兴趣或观点分成不同的群体,分析他们通常喜欢什么样的内容。

也就是说,如果你发的内容只受到你「本群体」的人欢迎、点赞再多,也不会让你上热榜。你必须说点什么、发个视频、做点什么,能让「立场不同的人」也愿意点个赞,才能让内容被更多人看到。

结果是:很快,各种网红、名人、内容创作者就开始尝试说一些能被不同立场人群同时接受的内容。他们在试错中意识到——这才是让内容「出圈」的唯一方式。

当然,这样的系统也不是没有缺点。有人会说,它可能会鼓励「从众」「妥协」「中庸」。

但不管怎么说,这至少是一个很有启发意义的例子:通过看起来非常简单的工程设定,就可以让一项技术从破坏信任,转变为重建信任。